Dal World Economic Forum (WEF) di Davos, Mark Zuckerberg ha comunicato, tramite un reel di Instagram, che Meta ha ordinato 350.000 GPU Nvidia H100. La spesa è paragonabile a metà di un bilancio finanziario italiano, per un consumo energetico superiore a quello della Lombardia. Ogni H100 consuma 700W, per un totale annuo di 1.300 GWh. Il costo totale di queste GPU si stima intorno ai 10,5 miliardi di dollari, senza considerare i costi energetici.

Ciao ciao, Europa!

Per dare un’idea della portata di questo investimento, il supercomputer italiano più potente, il Leonardo-1, ospita appena 14.000 GPU. Si, proprio il calcolatore di cui la stampa sta parlando in questi giorni perché è l’infrastruttura utilizzata dal Cineca e dall’azienda commerciale iGenius per creare il primo Foundation Large Language Model italiano. Vedremo cosa ne verrà fuori, ma difficilmente a breve termine vedremo qualcosa in grado di competere con i modelli di USA e Cina, come i media italiani spesso rilanciano.

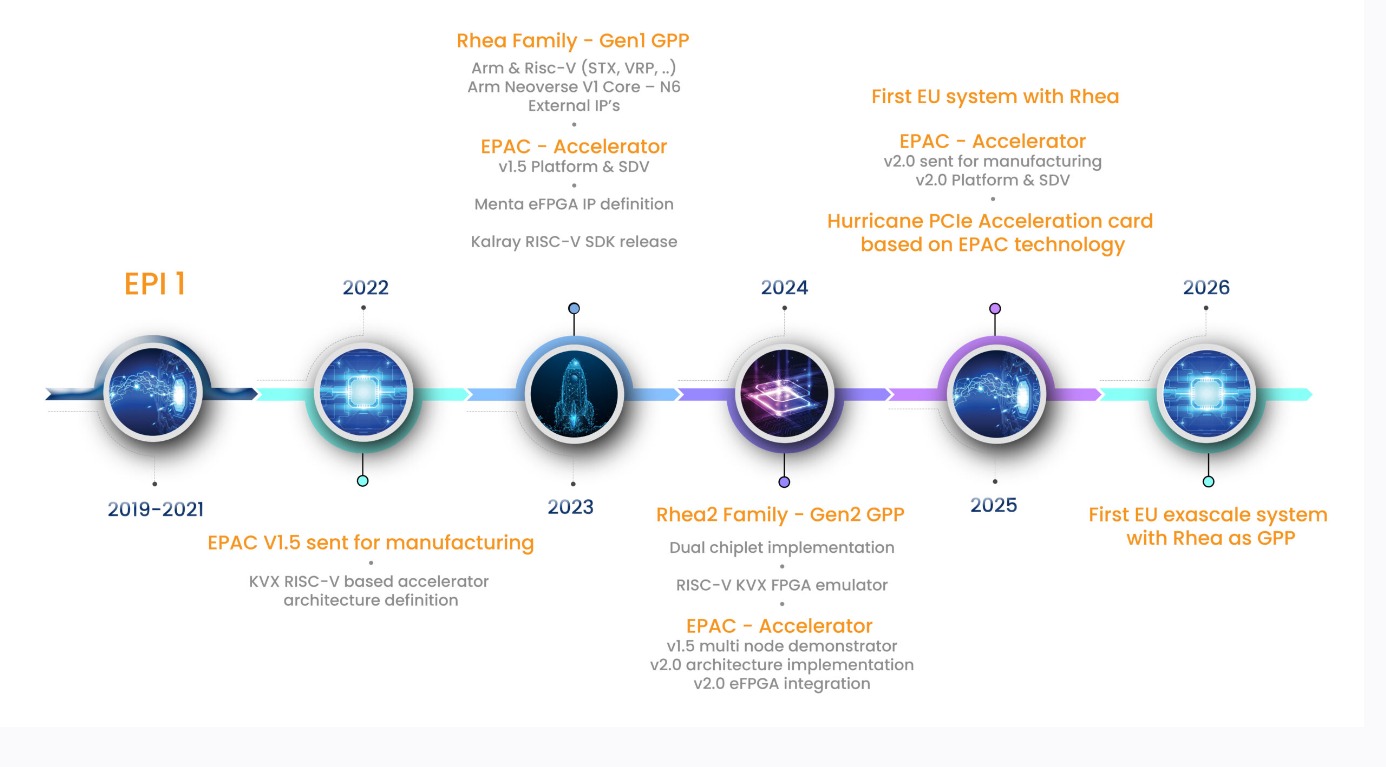

A medio termine qualche speranza invece c’è. La strategia europea dipende in buona parte dagli sviluppi della EPI, la European Processor Initiative. Il processore Rhea (che parte con matrici esistenti, Arm e Risc V) e gli acceleratori Epac dovrebbero confluire in un sistema exascale entro il 2026. Dopo bisognerà verificare quale foundry e con quale tecnologia si svilupperà un mercato europeo. Bisognerà poi verificare la reale spinta -diretta ed indiretta- che il Chips Act europeo potrà fornire a chip di queste caratteristiche. Tornando alle GPU, PC magazine valuta che nel 2023 i giganti tecnologici come Microsoft, Google e Amazon abbiano acquistato tra le 50.000 e le 150.000 Nvidia H100.

Il futuro dell’intelligenza artificiale

Nonostante un 2023 difficile per il progetto metaverso, Meta è fortemente impegnata nello sviluppo dell’IA, che viene considerata complementare al metaverso. Per favorire lo sviluppo di soluzioni innovative il team di ricerca sull’IA (FAIR) sarà fisicamente messo a contatto con quello che si occupa di progettare prodotti potenziati da IA.

Zuckerberg ha annunciato che Meta sta lavorando su LLama3, un modello di linguaggio previsto per superare ChatGPT e Gemini in tutti i test, che sarà rilasciato con licenza Open Source. E, addirittura, ha detto che vuole realizzare un’AGI (intelligenza artificiale generale, termine ambiguo per dire qualcosa “intelligente” quanto l’uomo).

Il 2024 è previsto come l’anno dell’AI di massa, che richiederà enormi quantità di energia elettrica e risorse per il suo mantenimento, ma rappresenterà un salto qualitativo per l’uso dell’IA in dispositivi di ogni tipo.